Sostituire le batterie alla luce di emergenza VIMAR 16450

Molto probabilmente anche voi avete a casa il frutto VIMAR 16450 attaccato a qualche presa (solitamente nei pressi dell’ingresso): il suo scopo è sostanzialmente quello di illuminare nel caso in cui manchi improvvisamente la corrente elettrica (utilizzando le proprie batterie interne).

Una funzionalità aggiunta molto carina è che staccandolo dalla presa può diventare una comoda torcia da portare in giro per illuminare le stanza buie.

Se non avete ancora capito a cosa mi riferisco ecco una foto del frutto (esiste anche nella versione bianca):

Dopo anni di funzionamento il primo componente a saltare sono le batterie quindi, se questo frutto non vi funziona, al 90% è quest’ultimo componente a necessitare di essere sostituito.

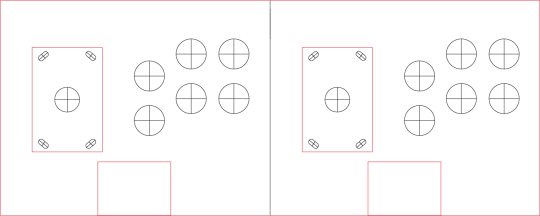

Esistono varie “revisioni” della VIMAR 16450, la versione più vecchia non ha le batterie rimovibili al contrario delle versioni più recenti; se avete una versione vecchia, non vi preoccupate, con un stagnatore ed un cacciavite a taglio si può facilmente porre rimedio al problema (non serve essere elettricisti, ve lo assicuro); considerate inoltre che questo frutto, nel caso in cui vogliate ricomprarlo, costa non meno di 70 €.

Ho deciso quindi di acquistare le batterie (4 €) e lo stagnatore (30 €) e in una decina di minuti ho ripristinato il funzionamento della torcia VIMAR 16450.

Le batterie ricaricabili originali erano delle Ni-Mh da 1,2V e 550mAh mentre quelle che ho acquistato sono delle Ni-Mh da 1,2V con 600 mAh (le potete trovare anche su Amazon).

L’unica cosa a cui prestare attenzione è la polarità delle batterie, quindi segnatevi la posizione prima di sostituirle.

Ho fatto delle foto con il frutto smontato, il circuito (in entrambi i lati) e le batterie utilizzate (quelle verdi); spero che tutto ciò vi sia d’aiuto.